Введение

Длительное время вопросы восприятия аффективных состояний человека изучались на материале статических изображений: фотографий, портретов, рисунков и схем, а основное внимание уделялось конфигурационным характеристикам и диагностическим признакам эмоциональных экспрессий. К восприятию выражений подвижного лица, его изменениям в реальном времени обратились в восьмидесятые годы прошедшего столетия. В отличие от статичных изображений видимые изменения мимики, перемещений глаз, движений губ и челюстей при артикуляции, наклоны головы и др. как бы оживляют неподвижные картины, наделяя их анемическими качествами. Предметом восприятия становится не столько пространственная организация мгновенных срезов лица, сколько структура их отношений: возникновение, развитие, переходы в иную модальность. Выражение лица описывается в терминах активности человека, которая конституирует межличностные ситуации и регулирует потоки субъект-субъектных взаимодействий.

По сравнению с фотографиями или схемами восприятие видеоизображений лица имеет ряд существенных отличий. Главное состоит в том, что эмоции в динамике распознаются более точно и быстро, чем в статике. С созданием условий, затрудняющих восприятие, величина эффекта возрастает. Это имеет место при слабой выраженности эмоции, сверхкоротких экспозициях, расфокусированности лица; его схематизации; исключении информации о текстуре и контуре [15—18]. С усилением экологической валидности условий восприятия, в том числе при экспозиции видеоизображений лица, эффект движения уменьшается либо не проявляется вовсе. Чем выше качество требуемой аффективной информации, тем менее заметно влияние временной составляющей и выше значение статичного «среза» выражения лица.

В отличие от статики распознавание динамических экспрессий опирается на более широкую информационную основу, обусловленную временной организацией выражения лица. Это открывает возможность наблюдать развитие эмоций в самом ходе межличностной коммуникации. Источником динамической информации выступает процесс порождения и развития экспрессий и его характеристики: длительность и плавность изменений, их направление, траектория, темп, интенсивность; гетерохронность проявления диагностических признаков и фазность развертывания выражения лица в целом. Так, если кадры динамической экспрессии демонстрируются в произвольном или реверсивном порядке, нарушая привычную последовательность, точность оценок значительно снижается [Bruce, 1998]. От траектории изменений выражения лица зависит соответствие воспринимаемой экспрессии действительному состоянию коммуниканта. Компьютерная анимация, при которой изменения лица происходят по кратчайшей прямой, приводит к замедленному и менее точному распознаванию эмоций, а также к более низким оценкам интенсивности, искренности и типичности по сравнению с действительным развертыванием экспрессии [Birmingham, 2007; Gelder, 2000]. В силу нелинейности и асинхронии активности мимических мышц при переживании эмоции, естественные динамические экспрессии и переходы между ними воспринимаются иначе, чем искусственные динамические последовательности, созданные путем линейного морфинга [Krumhuber, 2016]. Точность категоризации снижается при инверсии естественных видеофрагментов во времени [Барабанщиков, 2020; Krumhuber, 2016]. С увеличением или снижением скорости движения лица наблюдатели по-разному оценивают содержание и естественность выражения [Bould, 2008; Hill, 2005; Sato, 2004]. Оптимальная эффективность распознавания экспрессии каждой категории достигается при определенной скорости изменений лица [Kamachi, 2001; Recio, 2013]. Наблюдатели способны тонко дифференцировать информацию о подлинности воспринимаемой экспрессии — того, что в действительности должно происходить при реальном переживании. На начальных стадиях возникновения улыбки меньшая продолжительность и менее упорядоченные лицевые акты больше говорят о вежливости, чем о веселье, а также о меньшей искренности и непосредственности [Ambadar, 2009; Hess, 1994; Krumhuber, 2005]. В зависимости от содержания и логики развития коммуникативной ситуации источники динамической информации по-разному используются как по отдельности, так и в различных комбинациях друг с другом, образующих динамические паттерны мультимодальных выражений аффективных состояний.

В отличие от статических изображений экспозиция «живого» лица вводит дополнительный функционал. Наряду с размером, формой, межзрачковым расстоянием и цветом глаз, значимой становится направленность взора коммуникантов [Adams, 2003; Bindemann, 2008; Langton, 2011]. Осуществляется зрительный контакт — обмен взглядами, благодаря которому открывается уникальный информационный канал, связывающий участников общения и позволяющий каждому из них как бы непосредственно проникать во внутренний мир партнера. Усиливается роль бровей, благодаря которым контролируется взаимное внимание. Во время разговора движения губ, языка, нижней челюсти, проглядывания зубов обеспечивают условия адекватного восприятия речи партнера [Bruce, 1998; McGurk, 1976]. Идентификация динамических экспрессий сопровождается непроизвольными изменениями лица наблюдателя, имитирующими экспонируемые эмоции — эмоциональной мимикрией [Sato, 2004]. Испытуемым, которым запрещалось имитировать видимые переживания, требовалось больше времени, чтобы определить момент смены валентности состояния на противоположное по сравнению с ситуацией, когда имитация разрешалась [Niedenthal, 2001]. При блокировке подражаний подлинность экспрессий и искренность улыбок по их динамическим качествам не определяются [Maringer, 2011].

Обращение к динамике выражения лица позволяет более глубоко изучать природу и механизмы мультимодальных аффективных состояний. Эмоции проявляются не только в мимике или направленности взора, но и в интонациях голоса, жестах, положениях тела, походке. В каких-то случаях при выражении одного и того же переживания разномодальные экспрессии согласуются между собой, дополняя и поддерживая друг друга, в каких-то — вступают в противоречие, подавляя друг друга и разрушая общее впечатление об эмоции. Конгруэнтность либо неконгруэнтность сочетаний различных модальностей способны как усиливать, так и ослаблять точность идентификации аффективных состояний, менять видимую валентность и семантическое содержание [Baart, 2018; Cunningham, 2009; Korolkova, 2018; Massaro, 1996]. В данном контексте исследуются взаимовлияния выражений и восприятия экспрессий лица и голоса, лица и тела. Раскрыты условия, обеспечивающие преимущества той или иной модальности, роль перцептивного и концептуального сходства, характер иррелевантных оценок, эффекты адаптации, динамика вклада унимодальных экспрессий в мультимодальное целое и др. [Барабанщиков, 2016; Барабанщиков, 2020; Лупенко, 2022; Aviezer, 2008].

На сегодняшний день динамический аспект восприятия эмоциональных состояний человека по выражению его лица является одним из перспективных направлений экспериментально-психологического исследования. Оно ориентировано на достижение высокого уровня экологической и социальной валидности, системный поиск закономерностей категоризации эмоциональных экспрессий в естественных ситуациях, углубление представлений о природе невербальной коммуникации, поиск механизмов кроссмодальной интеграции разнотипных экспрессий и др.

Основной объем выполненных исследований по тематике подвижного лица касается закономерностей зрительной модальности самой по себе и не часто сопрягается с другими источниками аффективной информации, актуализируемыми в текущий момент времени. В ходе непосредственного общения сенсорные каналы каждого из участников внутренне согласованы, взаимосвязаны и синхронизированы. Динамика выражения лица сопровождается определенным направлением взора, отнюдь не случайным поворотом головы, изменениями положения тела, своеобразной жестикуляцией, характерными интонациями речи и др., которые выступают как единый ансамбль эмоциональных проявлений человека. Место и функциональные возможности подвижного выражения лица как относительно самостоятельной образующей мультимодального целого остаются не всегда понятными.

В только что опубликованной работе [Барабанщиков, 2024] мы рассмотрели круг возможностей, которыми обладает просодическая образующая бимодального аффективного состояния, включающего интонации голоса и выражения лица. Согласно экспериментальным данным, вокальные экспрессии отличаются от соответствующих мультимодальных состояний низкой точностью выражения и идентификации, иной конфигурацией и высоким разбросом оценок, более тесной зависимостью от степени возбуждения, индивидуальными способами выражения и нечеткой расширенной структурой категориальных полей.

Цель новой работы состоит в том, чтобы экспериментально раскрыть специфику выражения и восприятия лицевой образующей бимодальных аффективных состояний. Задачи исследования: 1) разработка методики изучения особенностей выражения и восприятия эмоционального состояния человека по выражениям подвижного лица как части мультимодального целого; 2) анализ характеристик точности и семантической структуры выражения и идентификации лицевых экспрессий и их зависимости от условий экспозиции; 3) соотнесение основных метрик выражения и идентификации лицевых, просодических и мультимодальных эмоциональных состояний.

Методика

В основу методики положен Женевский тест распознавания эмоций (Geneva Emotion Recognition Test — GERT), предназначенный для изучения выражения и идентификации мультимодальных динамических эмоциональных состояний человека [46—48]. Тест особенно интересен расширенным набором аудиовидеоизображений ключевых эмоций, который создавался при участии профессиональных актеров и известного режиссера. В работе с актерами использовался метод переживания К.С. Станиславского, благодаря которому создавалось настроение, инициирующее требуемое функциональное состояние. Аудиовидеоклипы включали мимику, жесты, движение глаз и головы, а также псевдолингвистические фразы, содержащие интонации выражаемой эмоции. Использовались две формы высказываний: a) с восклицательной интонацией — «Ne kali bam sud molen!»; б) с вопросительной — «Kun se mina lod belam?». По смысловому значению: a) «Не могу в это поверить!»; и б) «Ты действительно так считаешь?». Аудиозаписи актеров-дикторов различаются ударениями, паузами, тембром, темпом и тоном речи, которые в совокупности создают уникальные способы вокализации эмоциональных состояний.

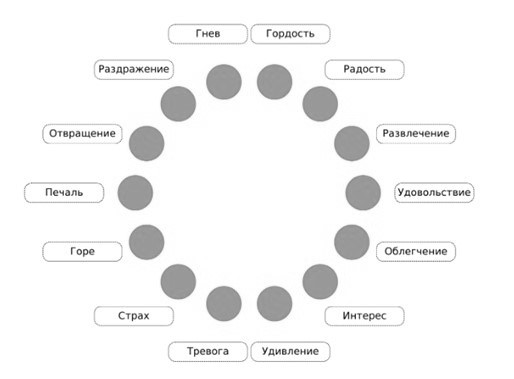

Организация стимульного материала, средства его оценки и интерпретация данных построены на концепте Женевского колеса эмоции — объединении в круг 14 категорий эмоциональных состояний, проранжированных в зависимости от их валентности и степени возбуждения [Barrett, 1999; Cosker, 2010; Cutting, 1977; Niedenthal, 2001]. Женевское колесо включает 4 аффективных объединения и три отдельные эмоции. Гордость, развлечение, радость, удовольствие и облегчение образуют группу состояний с положительной валентностью (группа А); в нее входят различные формы выражения достижений человека, которые часто наблюдаются в социальных ситуациях. В группах состояний с отрицательной валентностью (B, C и D) однотипные эмоции разделены по степени возбуждения. Группа B объединяет тревогу и страх; группа C — печаль и горе; группа D — раздражение и гнев. Отвращение, а также амбивалентные эмоции интереса и удивления рассматриваются как независимые состояния. В силу внутренней структуры Женевского колеса эмоциональные состояния не только разделяются на дискретные единицы, но и пересекаются или соседствуют по линиям сходной валентности или близкой степени возбуждения. Необычные конструктивные особенности методики обусловлены решением авторами главной теоретико-методологическая задача [Schlegel, 2014] — поиском путей оценки аффективных состояний, преодолевающих антагонизм категориального [Cutting, 1977; Hill, 2005] и многомерного [Baart, 2018; Niedenthal, 2001] подходов.

Наше исследование проводилось в рамках русскоязычной версии GERT, в которой реализована схема и ключевые звенья оригинала [4—8]. Эксперимент включал две серии. В одной испытуемым демонстрировались бимодальные аффективные состояния (выражения лица + интонации голос), в другой — только динамические выражения лица. Акустический компонент удалялся с помощью программы iMovie. От испытуемых требовалось определить содержание воспринятой эмоции, коснувшись соответствующей надписи на изображении Женевского колеса. Техническая реализация эксперимента осуществлялась на электронных платформах Vercel, Google Sheets.

Участники исследования. В экспериментах приняли участие студентки и аспирантки российских вузов, постоянно проживающие в г. Москве. Выборка для оценки лицевых экспрессий включала 72 женщины в возрасте 18—45 лет (M=22,4 года, SD — 5,4 лет); выборка для оценок мультимодальных экспозиций — 72 женщины в возрасте 18—45 лет (M=22,5, SD — 5,7).

Аппаратура. Исследование проводилось в лаборатории Института экспериментальной психологии МГППУ на компьютерах SINTO (AMD Ryzen 3 3100, Radeon RX570, 8 GB ОЗУ) с мониторами Acer XF252QXbmiiprzx (23,5”, 1920х1080 px.), использовались наушники Sennheiser HD555 (15-28кГц, 113 дб), Canyon CNR-HS01N (20-20кГц, 106 дб), Logitech H111 (20-20кГц, 100 дб). Дисплей располагался на расстоянии 60см от лица испытуемого. Размер изображения — около 18×24°, лица — 8×10°. Громкость и качество звука настраивались испытуемыми индивидуально.

Рис. 1.Снимок экрана интерактивной версии Женевского колеса эмоций

Процедура. На начальном этапе участникам исследования сообщались технические требования, инструкция и определения тестируемых эмоциональных состояний; предоставлялась возможность настроить звук. После выполнения тренировочных заданий участник имел возможность вернуться к инструкции повторно.

Во время основной сессии в зависимости от назначения группы, участникам последовательно, в случайном порядке, предъявлялись 83 видеозаписи либо аудиовидеозаписи эмоциональных экспрессий десяти актеров (5 мужчин и 5 женщин, средний возраст 37 лет). Распределение натурщиков по аудиовидеоклипам было неравномерным. Экспрессии отвращения, печали, горя, удивления выражены четырьмя актерами, гнев и гордость — пятью, радость, развлечение, удовольствие, облегчение, интерес, тревога, страх, раздражение — шестью. Одни и те же актеры могли участвовать в проигрывании состояний в разных объединениях: по шесть, в отдельных случаях по пять эмоций [Барабанщиков, 2022а]. Каждая экспозиция демонстрировалась один раз на 2—5 с без возможности повтора; после его демонстрации на экране дисплея предъявлялось изображение Колеса эмоций (рис. 1). Переход к следующей экспозиции осуществлялся автоматически после выбора категории и касания на экране соответствующего круга. Программа исследования завершалась высвечиванием на экране усредненного результата точности распознавания, полученного испытуемым, и его отчетом об особенностях выполнения задания.

Обработка данных. Анализировались усредненные показатели распознавания предъявляемых стимулов, их отношения и зависимости. При анализе структуры категориальных полей использовались усредненные оценки каждой из категории с порогом узнавания выше 0,05. Ответы участников перекодировались в цифровые значения категорий от 1 до 14 соответственно. Полученные данные проходили предварительную обработку в MS Office, Excel 2010. Для целей статистического анализа использовался пакет программ — SPSS 22.0. Взаимосвязь средней точности оценок демонстрируемых состояний с полом натурщиков определялась с помощью коэффициентов корреляции Спирмена (p<0,05). В качестве статистических критериев применялись: критерий c2 Фридмана, критерий Манна—Уитни, Краскелла—Уолиса с уровнем значимости p<0,01; критерий Вилкоксона с уровнем значимости p<0,05; G-критерий Макнемара (для зависимых выборок) с уровнем значимости p<0,05.

Результаты и обсуждение

Усредненная частота выбора уни- и мультимодальных состояний актеров-натурщиков в зависимости от содержания эмоций представлена в табл. 1 и 2. По горизонтали локализованы целевые состояния, по вертикали — оценки наблюдателей. Релевантные ответы, характеризующие точность идентификации, показаны вдоль основной диагонали, иррелевантные, указывающие на воспринятое сходство с целевой экспрессией, расположены вдоль вертикали. Аффективные профили (совокупность значений каждого из столбцов) демонстрируют семантическую структуру целевого аффективного состояния. Рассмотрим полученные матрицы более подробно.

Таблица 1. Матрица оценок лицевых экспрессий эмоциональных состояний натурщиков

|

Состояния |

Гордость |

Радость |

Развлечение |

Удовольствие |

Облегчение |

Интерес |

Удивление |

Тревога |

Страх |

Горе |

Печаль |

Отвращение |

Раздражение |

Гнев |

|

Гордость |

0,63 |

0,05 |

0,00 |

0,14 |

0,06 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

0,01 |

0,00 |

0,01 |

0,00 |

|

Радость |

0,11 |

0,67 |

0,39 |

0,05 |

0,02 |

0,01 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

|

Развлечение |

0,04 |

0,06 |

0,38 |

0,06 |

0,01 |

0,02 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

0,01 |

0,00 |

|

Удовольствие |

0,12 |

0,03 |

0,08 |

0,55 |

0,13 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

0,00 |

|

Облегчение |

0,01 |

0,03 |

0,02 |

0,10 |

0,61 |

0,01 |

0,02 |

0,02 |

0,00 |

0,00 |

0,03 |

0,00 |

0,01 |

0,00 |

|

Интерес |

0,01 |

0,02 |

0,00 |

0,08 |

0,05 |

0,51 |

0,08 |

0,07 |

0,00 |

0,00 |

0,01 |

0,00 |

0,03 |

0,00 |

|

Удивление |

0,00 |

0,12 |

0,02 |

0,00 |

0,01 |

0,17 |

0,44 |

0,16 |

0,05 |

0,00 |

0,02 |

0,00 |

0,04 |

0,00 |

|

Тревога |

0,00 |

0,00 |

0,00 |

0,00 |

0,01 |

0,06 |

0,11 |

0,40 |

0,19 |

0,12 |

0,11 |

0,03 |

0,07 |

0,01 |

|

Страх |

0,01 |

0,00 |

0,00 |

0,00 |

0,00 |

0,02 |

0,13 |

0,22 |

0,38 |

0,10 |

0,02 |

0,08 |

0,04 |

0,01 |

|

Горе |

0,00 |

0,00 |

0,08 |

0,00 |

0,00 |

0,01 |

0,01 |

0,02 |

0,06 |

0,47 |

0,15 |

0,15 |

0,04 |

0,00 |

|

Печаль |

0,00 |

0,00 |

0,01 |

0,00 |

0,01 |

0,01 |

0,01 |

0,04 |

0,01 |

0,15 |

0,57 |

0,12 |

0,01 |

0,00 |

|

Отвращение |

0,00 |

0,00 |

0,00 |

0,01 |

0,01 |

0,03 |

0,10 |

0,04 |

0,00 |

0,01 |

0,06 |

0,55 |

0,07 |

0,00 |

|

Раздражение |

0,03 |

0,01 |

0,00 |

0,01 |

0,05 |

0,13 |

0,08 |

0,03 |

0,09 |

0,10 |

0,02 |

0,06 |

0,58 |

0,30 |

|

Гнев |

0,03 |

0,00 |

0,00 |

0,00 |

0,00 |

0,01 |

0,02 |

0,00 |

0,20 |

0,05 |

0,00 |

0,01 |

0,09 |

0,67 |

Таблица 2. Матрица оценок мультимодальных динамических эмоциональных состояний натурщиков

|

Состояния |

Гордость |

Радость |

Развлечение |

Удовольствие |

Облегчение |

Интерес |

Удивление |

Тревога |

Страх |

Горе |

Печаль |

Отвращение |

Раздражение |

Гнев |

|

Гордость |

0,47 |

0,09 |

0 |

0,04 |

0,02 |

0,01 |

0 |

0 |

0 |

0 |

0 |

0 |

0,01 |

0 |

|

Радость |

0,16 |

0,76 |

0,18 |

0,04 |

0,02 |

0,02 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

|

Развлечение |

0,06 |

0,06 |

0,68 |

0,01 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

|

Удовольствие |

0,1 |

0,01 |

0,03 |

0,79 |

0,12 |

0,01 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

|

Облегчение |

0,01 |

0,03 |

0,01 |

0,06 |

0,77 |

0,02 |

0,01 |

0,02 |

0 |

0 |

0,02 |

0 |

0,02 |

0 |

|

Интерес |

0,09 |

0,01 |

0 |

0,05 |

0,02 |

0,57 |

0,11 |

0,06 |

0 |

0 |

0,01 |

0 |

0,06 |

0 |

|

Удивление |

0,01 |

0,04 |

0,05 |

0 |

0 |

0,14 |

0,65 |

0,16 |

0,03 |

0 |

0,01 |

0,03 |

0,05 |

0 |

|

Тревога |

0 |

0 |

0 |

0 |

0 |

0,02 |

0,1 |

0,58 |

0,12 |

0,11 |

0,02 |

0,03 |

0,04 |

0 |

|

Страх |

0 |

0 |

0 |

0 |

0 |

0 |

0,02 |

0,13 |

0,6 |

0,08 |

0,01 |

0,02 |

0 |

0 |

|

Горе |

0 |

0 |

0,02 |

0 |

0,01 |

0,02 |

0,02 |

0,02 |

0,13 |

0,61 |

0,22 |

0,08 |

0,02 |

0,01 |

|

Печаль |

0 |

0 |

0 |

0 |

0 |

0,03 |

0,01 |

0,03 |

0 |

0,12 |

0,66 |

0,07 |

0,01 |

0 |

|

Отвращение |

0,01 |

0 |

0,01 |

0 |

0,01 |

0,03 |

0,03 |

0 |

0 |

0,02 |

0,03 |

0,65 |

0,08 |

0 |

|

Раздражение |

0,05 |

0 |

0 |

0 |

0,02 |

0,12 |

0,06 |

0 |

0,03 |

0,03 |

0,02 |

0,1 |

0,67 |

0,22 |

|

Гнев |

0,02 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0,08 |

0,03 |

0 |

0,01 |

0,04 |

0,75 |

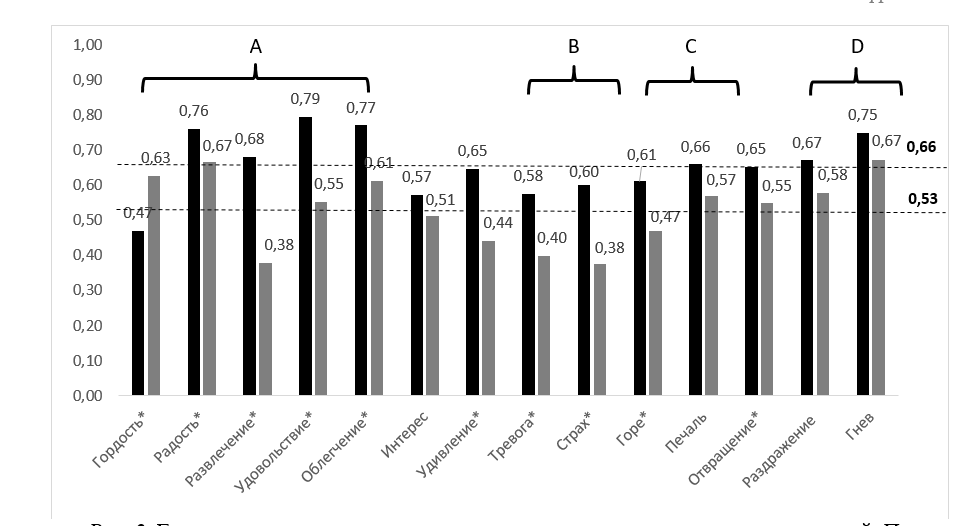

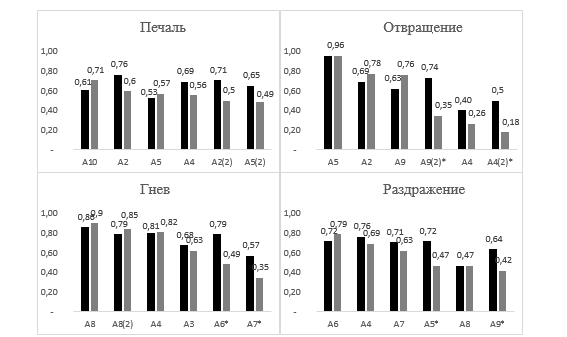

Точность идентификации лицевых экспрессий. Распределение частоты релевантного выбора лицевых и мультимодальных экспрессий показано на рис. 2. Средняя точность распознавания эмоции по выражению лица (М = 0,53, SD = +/–0,09) в 1,24 раза ниже соответствующей оценки мультимодальных состояний (М = 0,66, SD = +/–0,1). Максимально точно воспринимаются гнев (0,67), радость (0,67), гордость (0,63) и облегчение (0,61). Хуже всего оцениваются страх (0,38), развлечение (0,38) и тревога (0,4). Наибольшее различие релевантных оценок мультимодальных и лицевых эмоций получено на экспозициях развлечения (в 1,8 раз). При сравнении лицевых и мультимодальных экспозиций различия статистически значимы для эмоций гордости (U=926, р<0,01), радости (U=1233,5, р<0,01), развлечения (U=720, р<0,01), удовольствия (U=653, р<0,01), облегчения (U=975,5, р<0,01), удивления (U=889, р<0,01), тревоги (U=1036,5, р<0,01), страха (U=1030, р<0,01), горя (U=1207, р<0,01), отвращения (U=1237,5, р<0,01). Точность оценок выражений интереса, печали, отвращения, и гнева — от унимодальной образующей не отличается. Единственной лицевой экспрессией, которая статистически идентифицируется лучше мультимодальных, является гордость (U=926, р<0,01).

Рис. 2. Гистограммы точности распознавания уни- и мультимодальных состояний. По горизонтали — категории эмоций, по вертикали — частота релевантных ответов испытуемых. Цифры сверху — средние значения частоты ответов для каждой эмоции; пунктирные линии — средние значения частоты ответов на экспозиции уни- и мультимодальных экспрессий, звездочкой отмечены значимые различия. A, B, C, D — аффективные группы. — лицевые экспрессии; — мультимодальные экспрессии

Несмотря на различия, рейтинги частот релевантных ответов при экспозициях лицевых и мультимодальных экспрессий в целом похожи. В каждом из перечней на первых позициях стоят удовольствие и облегчение, на последних — интерес и гордость, в середине — развлечения, раздражение, удивление, горе.

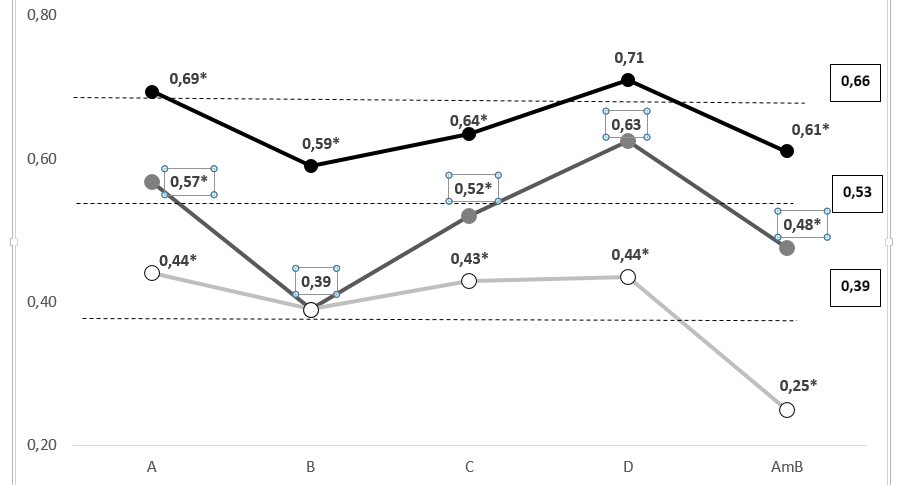

Зависимости точности идентификации уни- и мультимодальных выражений от валентности эмоций представлены на рис. 3. Релевантные ответы наблюдателей распределены по статистически различным уровням точности и имеют похожие конфигурации. Нижний уровень образуют оценки вокальных экспрессий, полученные авторами статьи ранее [Барабанщиков, 2024]. Для него характерна инвариантность средних значений, как при положительной (группа А), так и при отрицательной (группы B, C, D) валентности, дополненная резким падением точности идентификации амбивалентных состояний. Распознавание лицевых и мультимодальных состояний различается не просто более высокими значениями, но и монотонным ростом оценок эмоций с отрицательной валентностью: B→C→D; снижение частоты релевантных выборов амбивалентных экспрессий происходит более плавно. Усредненные идентификации мультимодальных экспозиций отличаются от точности оценок унимодальных экспрессий во всех эффективных группах, за исключением D: для лицевых выражений — UA = 456, UB = 672,5, Uс=644,5, UAmb = 401,1, p<0,01; для вокальных: UA = 335, UB = 1096, Uс=1132,5, UAmb = 244,5, UD=881,5, p<0,01. При экспозиции каждой из унимодальных экспрессий в отдельности усредненные оценки группы B совпадают. При экспозиции лицевых и мультимодальных экспрессий статистические значимые различия оценок группы D не обнаружены.

Безотносительно к типу модальности демонстрируемых состояний выделяются три тенденции: 1) средняя либо высокая точность распознавания эмоций положительной валентности (группа A); 2) инвариантность либо монотонный рост точности оценок негативных состояний (группы B, C, D); 3) низкая и очень низкая точность идентификации амбивалентных эмоций (Amb). С точки зрения образования мультимодального целого и его восприятия определяющая роль лицевой образующей выглядит убедительно.

Рис. 3. Средняя точность идентификации аффективных групп вокальных, лицевыхи мультимодальных экспрессий. A, В, C, D — аффективные группы, Аmb — амбивалентные эмоции; цифры сверху — значение частоты ответов; цифры в рамке справа — средние значения по каждой серии, звездочкой отмечены значимые различия. — мультимодальные экспрессии, — лицевые экспрессии,

— вокальные экспрессии

Среди локальных результатов эксперимента целесообразно отметить высокую точность оценок видимой гордости. Это показывает, что при исключении просодической информации кроссмодальная интеграция предполагает не просто суммирование возможностей каждой из унимодальных образующих, но и их более сложные отношения. Возникает представление о множественности сочетаний разномодальных оценок эмоциональных состояний людей в экологически валидных условиях экспозиции и соответствующих ей интеграционных механизмах.

Ранее мы убедились, что при экспозиции вокальных экспрессий аффективных групп B, C, D имеет место линейная зависимость результатов распознавания от степени возбуждения эмоции: чем оно выше, тем точнее оценка. В условиях динамики лицевых экспрессий подобная зависимость зарегистрирована только в группе D: раздражение (0,58) → гнев (0,67), z = –2,893, p<0,01. Для мультимодальных состояний значимый рост точности оценок также проявляется только в этой группе: раздражение (0,67) → гнев (0,75), z = –2,412, p<0,05. Интеграция унимодальных зависимостей способна приводить и к расширению (усилению), и к ограничению (ослаблению) связи между точностью идентификации и степенью возбуждения эмоции. Порождение нового качества предполагает новый тип связи воспринимаемого целого.

Выражение и восприятие лицевых экспрессий. В актах межличностного взаимодействия точность идентификации аффективного состояния натурщика определяется корректностью его выражения. Чем полнее и четче проявляется эмоция, тем выше ее оценка наблюдателем; снижение средней точности оценок свидетельствует о более низкой адекватности экспрессий. Результат идентификации характеризует и самое выражение аффективного состояния.

В выполненном исследовании каждый из актеров-натурщиков использовал индивидуальные способы и стили выражения эмоций, которые по-разному проявляются в меняющихся особенностях мимики, направленности взора, стратегиях окуломоторной активности, покачиваниях и наклонах головы, изменениях формы губ во время артикулирования и многом другом. Их совокупность представляет сложноорганизованный динамический паттерн, в котором ведущую роль играют мимика и взгляд.

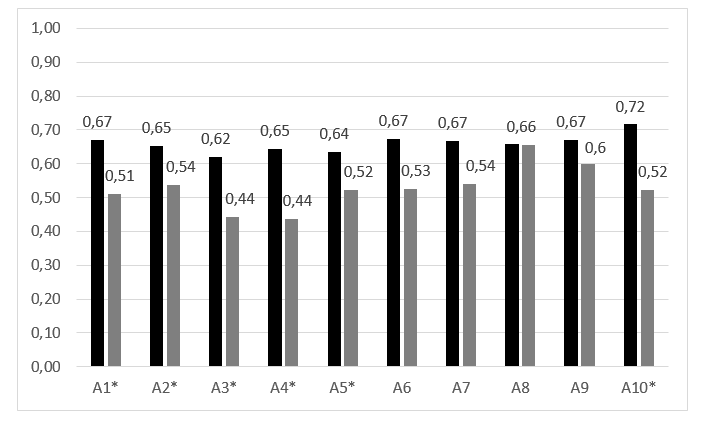

Рис. 4. Соотношение средней точности уни- и мультимодальных эмоциональных состояний, выраженных актерами (An), звездочкой отмечены значимые различия. — лицевые экспрессии; — мультимодальные экспрессии

На рис. 4 показаны средние значения идентификации лицевых и мультимодальных состояний, выраженных каждым из натурщиков. По сравнению с мультимодальными точность динамических выражений лица уступает, но не так сильно, как в случае просодических экспозиций: статистически значимые различия в оценках лица продемонстрировали шесть натурщиков А1, А2, А3, А4, А5, А10, при вокализации — девять. Максимальная полнота лицевых экспрессий, достигнутая А8 (0,66) буквально совпадает со средней точностью выражения этого же актера при мультимодальной экспозиции. Если разброс точности выражения унимодальных состояний остается одним и тем же, то в условиях мультимодальности он сужается более чем в два раза.

По точности выражения лицевых экспрессий натурщиков можно разделить на три группы: успешные (умелые) — A6, А8 и А9, малоуспешные — А3 и А4, умеренно успешные — А1, А2, А5, А7, А10. При сопоставлении с аналогичными группами этих же натурщиков в условиях мультимодальной экспозиции [Барабанщиков, 2022а]получено почти полное совпадение; единственное различие коснулось взаимозамены А8 на А10. Уже сам этот факт указывает на ведущую роль динамики лица в выражении мультимодальных состояний. При вокализации эмоций имеет место иной рейтинг и другая дифференциация способности тех же самых натурщиков: успешные — А7, А1, А10; малоуспешные — А2, А3, А8, А9, умеренно успешные — А4, А5, А6 [Барабанщиков, 2022а]. Лидеры лицевых и мультимодальных выражений при экспозиции вокальных экспрессий нередко оказываются аутсайдерами, и наоборот. Некоторое сходство с носителями мультимодальных экспрессий, безусловно, присутствует и здесь, но не является прямым и определяющим в достижении мультимодального эффекта. В любом случае выражения каждого типа унимодальных состояний предполагают разные способности коммуниканта и необходимость их интеграции в условиях мультимодальности.

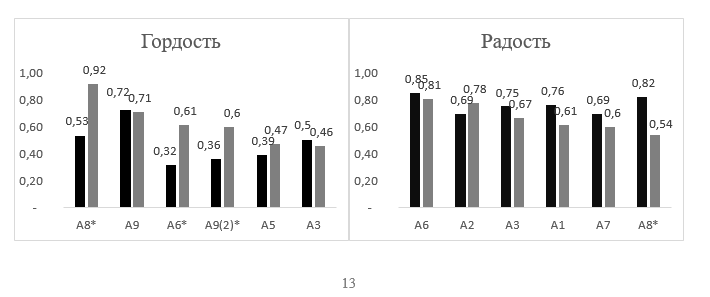

Более дифференцированно модальная специфика лицевых экспрессий просматривается на уровне отдельных категорий. На Рис. 5 приведены рейтинги корректности выражений лица актеров-натурщиков в зависимости от содержания переживаемых эмоций. Можно заметить, что с изменением целевой категории рейтинги натурщиков меняются. Например, А2 и А7 достаточно полно проявили себя на экспозициях тревоги и страха, но плохо выразили горе и гнев. Здесь нет абсолютных лидеров или аутсайдеров. «Чемпионом» по точности выражения аффективных состояний трижды становится А6 (экспрессии радости, удивления и раздражения). Но он же при экспозиции тревоги оказывается на последней ступени рейтинга. А3 и А4 можно отнести к относительным аутсайдерам: первый занимает эту позицию трижды (экспрессии гордости, удивления и страха), второй — дважды (экспрессия облегчения и отвращения). Но ни один из них не входит в число лидеров. Чаще всего кто-то из актеров превосходит коллег в инсценировках одних эмоций, проигрывая в других.

Рис. 5. Рейтинги точности выражения лицевых экспрессий разными натурщиками в зависимости от содержания эмоций; вверху — целевая категория эмоции, внизу — идентификационные номера дикторов-актеров, An; An (2) указывает на участие одного и того же актера в демонстрации разных объединений эмоций, звездочкой отмечены значимые различия. — лицевые экспрессии; — мультимодальные экспрессии

Способность выражать лицевые экспрессии для каждого натурщика индивидуально-специфична и зависит от целевой категории. Сходные тенденции имеют место в условиях мультимодальный экспозиции, где различные выражения эмоций более уравновешены, а экспрессивные способности актеров равномерно распределены по группе натурщиков.

Суммарно 57% эмоциональных состояний, выраженных отдельно подвижным лицом и его объединением с голосом, статистически неразличимы; в 32% случаев преобладают мультимодальные, а в 5% случаев — лицевые экспрессии. Последние представлены натурщиками А8, А6, А9 (состояния гордости) и А7 (состояния страха).

Наряду с индивидуальными существуют групповые способы выражения и восприятия аффективных состояний, связанные, в частности, с половым диморфизмом [Campanella, 2007; Izard, 1991]. Исследования мультимодальных экспрессий показывают преимущества женщин в идентификации отдельных эмоций других женщин. Мужчины демонстрирует чуть более высокую аффективную насыщенность, которая лучше оценивается противоположным полом. При экспозиции мультимодальных состояний гендерная стилистика проявляется в 20% выражений мужчин (эмоции развлечения, удивления, раздражения) и в 7% выражений женщин (эмоция гордости) [Барабанщиков, 2022]. В работе, посвященной восприятию просодической образующей мультимодальных состояний, мы не обнаружили значимых корреляций ни между полом натурщика и точностью вокализации эмоции, ни между полом и точностью выражений мультимодальных (лицо + голос) экспрессий. Этот же результат повторился при экспозиции натурщиками подвижных лицевых экспрессий.

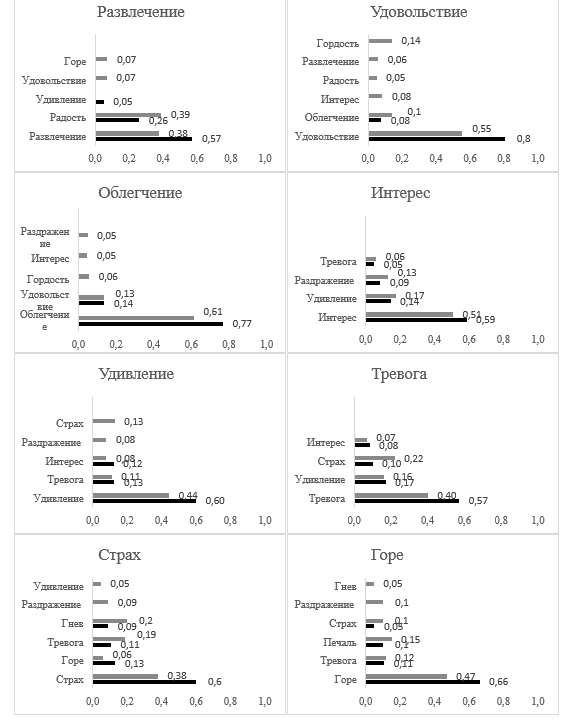

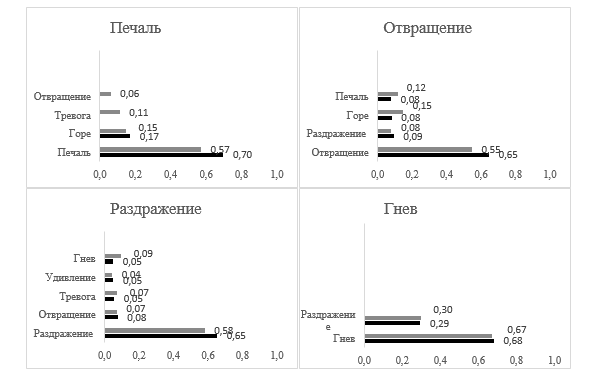

Категориальные поля лицевых экспрессий. Под категориальным полем аффективных состояний понимается состав и структура семантического содержания воспринимаемой эмоции. Его архитектоника включает ядро — наиболее точно идентифицируемое целевое выражение и периферию—экспрессивные компоненты, или признаки дополнительных эмоций, соответствующие иррелевантным ответам наблюдателей. Роль компонентов в структуре целого обусловлена их расположением на круговой шкале относительно целевой категории. В мультимодальной ситуации иррелевантные ответы чаще всего оказываются смежными (локализуются рядом) или соседствующими (опосредованы смежными) с целевыми. Чем дальше от цели смещены ответы, тем глубже периферия категориального поля [Барабанщиков, 2020а; Барабанщиков, 2022а], ядро и периферия находятся в реципрокных отношениях: снижение частоты релевантных ответов повышает вероятность расширения периферии и меняет соотношение ее компонентов.

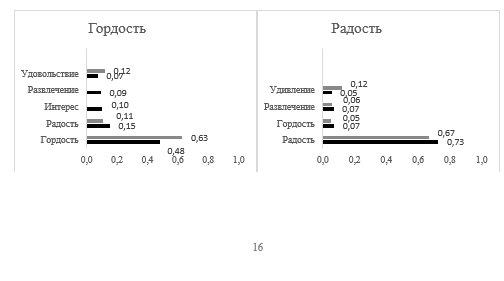

Ранее [Барабанщиков, 2020а] мы убедились, что категориальные поля мультимодальных состояний имеют четкую конфигурацию. Высокая точность идентификации целевых эмоций аффективных групп кратно превышает оценки дополнительных компонентов, которые с удалением от расположения цели снижаются по частоте, но остаются в границах заданной валентности. Категориальная конфигурация просодических экспрессий выглядит иначе. Она хуже определена, имеет низкие значения точности идентификации целевых состояний и увеличенное количество ассоциированных компонентов, охватывающих эмоции противоположной валентности. Экспрессивные примеси смещены в сторону дальней периферии, более вариативны и избирательны.

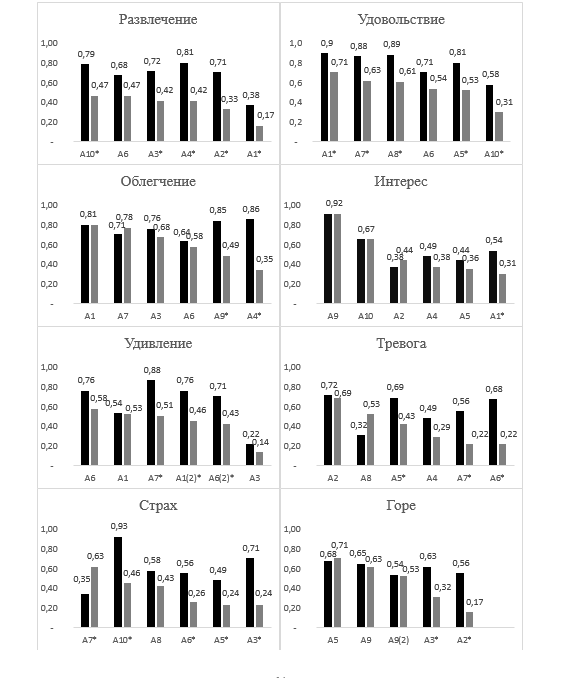

На Рис. 6 представлены структуры категориальных полей лицевых и мультимодальных выражений. В подавляющем большинстве случаев ядерные образования лицевых категориальных полей ниже (64%) либо равны (29%) мультимодальным. В условиях просодической экспозиции разрывы в точности оценок еще больше: ниже мультимодальных выражений 86% ответов, равны — 14%.

Рис. 6. Структуры категориальных полей лицевых и мультимодальных экспрессий. Вверху указаны категории экспонируемых эмоций, слева — категории ответов испытуемых, внизу — частота выбора (отмечены оценки ≥0,05). — лицевые экспрессии; — мультимодальные экспрессии

Периферия категориальных полей лицевых экспрессий состоит из двух—шести дополнительных компонентов (М = 3,2; SD= 1,3), объединенных экспрессий (лицо + голос) — из одного—четырех (М = 2,1; SD=1,2). Разность в содержании компонентов одной и той же эмоции для уни- и мультимодальной экспозиции может доходить до четырех промежуточных категорий, т. е. включает дальнюю зону периферии. По широте охвата дополнительных компонентов лицевые экспрессии больше напоминают вокальные, где описываемые тенденции выглядят фактурнее за счет пяти-шестикомпонентных экспрессий и увеличенного числа исключений (локальных эксцессов точности оценок). Содержания дальних периферий разнотипных унимодальных состояний редко совпадают, но могут иметь сходные компоненты.

Как и в условиях просодической экспозиции на лицевых экспрессиях возможно проявление компонентов, валентность которых отличается от целевой, но только для отдельных эмоций группы А: впечатления горя при экспозиции развлечения и развлечения при экспозиции облегчения; среди амбивалентных компонентов — удивление и интерес. На целевых экспрессиях групп B, C, D компоненты положительной валентности не встречаются, на амбивалентных эмоциях носят регулярный характер. Неадекватное восприятие валентности компонентов категориального поля по-разному проявляется в условиях уни- и мультимодальных экспозиций и может быть использовано в качестве критерия уровней организации аффективных образований.

Влияние степени возбуждения натурщика на конфигурацию категориальных полей в условиях экспозиции родственных лицевых экспрессий обнаружено только в группе D: раздражение (0,58) — гнев (0,67), z = –2,893, p<0,01. В отличие от состояния раздражения категориальное поле гнева имеет хорошо дифференцированное ядро (более высокую точность оценок) и периферию, суженную до одного дополнительного компонента (альтернатива многокомпонентной периферии раздражения). Эффект проявляется как при просодической, так и при мультимодальной экспрессиях.

Состав и сочетания компонентов унимодальных категориальных полей характеризуют качественное своеобразие лицевых и просодических экспрессий, которые в рамках мультимодального целого подвергаются преобразованиям: нивелированию отдельных компонентов, их трансформациям, возникновению новых компонентов и отношений. Признаки дополнительных эмоций непосредственно включены в интермодальные взаимодействия. Не только ядра, но и периферии семантически однородных категориальных полей являются участниками процесса кроссмодальной интеграции. Его содержанием выступает согласование возможностей унимодальных образующих с учетом требований коммуникативной ситуации и логики поведения коммуникантов.

Завершая обсуждение полученных результатов, отметим, что лицевые экспрессии, включенные в более объемное функциональное целое, отличаются как от просодических, так и от мультимодальных состояний. По совокупности ключевых показателей — точности выражения и восприятия, рейтингов ее конфигураций, зависимости от валентности и степени возбуждения, способов выражение, структуры и динамики категориальных полей — они имеют промежуточные значения, оставаясь выше оценок мелодики голоса, но ниже ее объединений с выражениями подвижного лица. Обладая более высоким экспрессивным потенциалом, лицевая образующая становится основой кроссмодальной интеграции. Благодаря возможностям просодической образующей этот процесс не просто дополняется и корректируется, но и развивается как относительно самостоятельное аффективное целое. Открывается перспектива более глубокого изучения механизмов восприятия мультимодальных эмоциональных состояний человека.

Выводы

Выполненное исследование позволяет охарактеризовать ряд ключевых особенностей выражения и восприятия лицевой образующей мультимодальных аффективных состояний.

- Средняя точность распознавания эмоций по выражению подвижного лица (M=0,53, SD=±0,09) в 1,24 раза ниже аналогичных оценок мультимодальных (M=0,66, SD=±0,1), но в 1,36 раза выше просодических (M=0,39, SD=0,16) экспрессий одного и того же пула аффективного состояний. В отличие от просодической образующей рейтинги точности идентификации категорий лицевых и мультимодальных выражений нередко совпадают. Распределение усредненных оценок аффективных групп мультимодальных состояний воспроизводит конфигурацию точности идентификации лицевых экспрессий.

- Объединения выражений лица и интонаций голоса в рамках одного и того же состояния способны не только повышать, но и понижать точность идентификации (экспрессия гордости). Кроссмодальные отношения не ограничены суммированием возможностей унимодальных образующих.

- Зависимость точности идентификации аффективных состояний от валентности эмоций опосредована модальностью их выражения. В совокупности релевантных ответов нижний уровень точности представлен оценками вокальных экспрессий, для которых характерна инвариантность средних значений, как положительной (группа А), так и отрицательной (группы B,C,D) валентности. Распознавания лицевых и мультимодальных состояний — уровни средней и высокой точности — отличаются монотонным ростом оценок состояний отрицательной валентности (тревога/страх → горе/печаль → раздражение/гнев). Относительно низкие оценки амбивалентных эмоций прослеживаются на всех уровнях точности.

- Линейная зависимость результатов распознавания родственных лицевых экспрессий от степени возбуждения зарегистрирована только по отношению к паре «раздражение—гнев», т.е. также, как и при мультимодальной экспозиции. Интеграция унимодальных образующих способна приводить как к новому качеству, так и к иному типу связей аффективных состояний.

- Рейтинги точности выражения аффективных состояний разными натурщиками обусловлены модальностью и содержанием эмоций. Дифференцированы три условные группы натурщиков: успешные (умелые), малоуспешные и умеренно успешные. Составы участников групп при демонстрации лицевых и мультимодальных выражений практически совпадают, при демонстрации вокальных экспрессий — радикально меняются. Выражение эмоции мимикой лица и интонацией голоса одним и тем же человеком требует разных способностей и их интеграции в условиях мультимодальных отношений. Значимые корреляции между точностью выражения эмоций мимикой лица и полом натурщика не обнаружены.

- Конфигурация категориальных полей подвижных лицевых экспрессий занимает положение между соответствующими образованиями просодических и мультимодальных состояний, ближе к последним. Обладая в целом хорошо дифференцированным ядром, по ширине охвата дополнительных компонентов лицевые экспрессии напоминают вокальные, но ограничены их количеством и возможностью смены валентности. Также, как и ядра унимодальных состояний, дополнительные эмоции включены в процесс кроссмодальной интеграции и в рамках нового целого подвержены преобразованиям.

- Обозначен экспрессивный потенциал лицевой образующей в системе мультимодальных отношений интонаций голоса и динамических экспрессий лица.