Введение

Состояние человека невольно выражается в его голосе, в том, что называют просодическими, вокальными или голосовыми экспрессиями. Благодаря их восприятию осуществляется возможность более полного и глубокого понимания партнеров по общению и способность адекватно выстраивать коммуникативные действия. Эмоциональная окраска речи включена в единый поведенческий континуум и тесно переплетается с семантически однородными проявлениями мимики, жестовой активностью, движениями тела и др. Логика взаимосвязи разнотипных, унимодальных экспрессий, как и закономерности восприятия мультимодальных состояний, относятся к числу актуальных тем экспериментально-психологического исследования [Андреева, 2013; Барабанщиков, 2020; Барабанщиков, 2020а; Барабанщиков, 2023; Лупенко, 2022; Barkhuysen, 2010; Bänziger, 2012; Paulmann, 2011; Scherer, 2005].

Наряду с собственно лингвистическим содержанием, голос передает значительные объемы информации о размерах тела говорящего, его поле, возрасте, здоровье, социальном статусе, чертах личности и, наиболее детально, об эмоциональном состоянии. Голосовые характеристики коррелируют как с мимическими выражениями базовых эмоций (радостью, печалью, удивлением, отвращением, гневом, страхом), так и с невербальными вокальными всплесками (смехом, криком, рыданиями),которые обусловлены не процессом генерации речи, а модификацией дыхания и, как правило, распознаются лучше, чем эмоционально-окрашенные высказывания, особенно в состоянии страха и отвращения [Витт, 1991; Морозов, 2011; Scherer, 1986; Scherer, 1996].

В ходе психоакустических исследований прослежена связь между физическими параметрами голоса и содержанием (категорией) переживаемой эмоции. Так, выражение радости отличается высокой средней частотой звучания, расширенным частотным спектром, большей средней интенсивностью и скоростью речи. Проявления грусти, напротив, связаны с низкой частотой и интенсивностью, нисходящим контуром высоты и замедлением речи. В число наиболее важных акустических переменных входят темп и высота звучания [Patel, 2011; Sauter, 2010; Scherer, 1986; Scherer, 1991].Рост высоты тона в конце фразы воспринимается как неуверенность и уступчивость говорящего либо как интерес к собеседнику. Падение высоты ассоциируется с радостью и удовольствием, повышение — с удивлением или страхом. При сильном возбуждении говорящего растет сила голоса, меняются значения его высоты и тембра. Понижение высоты в просодическом контуре связывается с эмоциями положительной валентности (удовольствием, радостью), повышение — с амбивалентными или отрицательными состояниями (удивление, страх). Тембр, или частотный спектр, голоса также взаимосвязан с различным эмоциональным содержанием: для гнева характерно усиление высоких обертонов, увеличение звонкости; для страха — их падение [Витт, 1991; Patel, 2011; Scherer, 1996].

Вероятность релевантного распознавания аффективных состояний по голосу широко варьирует, достигая в отдельных случаях более 80% и опускаясь ниже 20%. Многое зависит от содержания эмоции, способов ее выражения и восприятия, методов оценки, включения в текущие виды деятельности и общения и др. Например, в иноязычном общениирадость, грусть и гнев распознаются легче и точнее, чем страх и спокойное состояние. При этом ответы слушателей не всегда соответствуют содержанию демонстрируемой эмоции. Например, гордость часто воспринимается как удовлетворение, а любовь — как грусть. Возникающие рассогласования интерпретируются в терминах ошибок идентификации [Барабанщиков, 2020; Барабанщиков, 2023; Bryant, 2021].

В отличие от лицевых экспрессий распознавание состояний человека по его голосу выполняется значительно труднее (имеет более продолжительное время ответа) и менее точно. Вместе с тем оценки голосовых экспрессий под влиянием выражения лица могут быть изменены [Baart, 2018; Gelder, 2000].

Лучше всего на слух распознаются эмоции положительной валентности; эмоции отрицательной валентности адекватно оцениваются хуже, а оценки амбивалентных эмоций слабо согласуются между собой, характеризуя разнонаправленные тенденции [Борисова, 1989; Морозов, 2011; Schlegel, 2012].

Пол и возраст влияют на выражение и восприятие вокальных экспрессий многозначно и очень дифференцированно. Как слушатели, женщины лучше мужчин распознают эмоции, заключенные в псевдолингвистических высказываниях. Если тон голоса указывает на отвращение или гнев, точность идентификации для обоих полов нередко одинакова. Не всегда обнаруживаются преимущества женщин в распознавании радости, печали и страха. Вместе с тем точность определения состояний по голосу часто повышается, когда он принадлежит представителям слабого пола. Наиболее высокие результаты достигаются при озвучивании состояния отвращения. Женщины лучше распознают проявления радости, произносимые женщинами, при этом точнее определяют отвращение, гнев, грусть и спокойное состояние, выраженное мужчинами [Борисова, 1989; Gelder, 2000; Lausen, 2018; Sen, 2018].

Возраст молодых слушателей влияет на восприятие вокальных экспрессий в большей степени, чем зрелых и пожилых. При этом эмоции молодых дикторов распознаются лучше особенно молодыми людьми. Возраст выражающих эмоцию влияет на точность идентификации сильнее, чем возраст слушателей. Акустические параметры голоса по-разному влияют на выражение эмоций молодыми и пожилыми дикторами. На разных возрастных этапах женщины в целом лучше справляются с задачами на точность распознавания просодических экспрессий [Cortes, 2021; Lambrecht, 2012; Sen, 2018].

Вопрос адекватности выражения эмоциональных состояний по интонации голоса не получил однозначного решения. Спонтанные эмоции, возникающие в конкретных жизненных ситуациях, распознаются примерно так же, как и постановочные, сыгранные актерами. Различия проявляются в предпочтениях того или иного содержания: страх и гнев более точно выражается актерами-дикторами, грусть — в спонтанно создаваемых условиях обычными людьми. Главным требованием к адекватному выражению вокальных экспрессий является способность говорящего лично переживать демонстрируемое состояние [Юрьева, 2020; Jürgens, 2015; Williams; Wilting, 2006].

В большинстве экспериментальных работ обсуждаемой темы оценки эмоций по голосу изучаются на материале акустической модальности как таковой, а их соотношения с аналогичными оценками экспрессий в зрительной и других модальностях носят рядоположный внешний характер. В процессе непосредственного общения разнородные каналы сенсорный информации актуализируются синхронно, в соответствии с общей задачей текущего поведения, и взаимообусловливают друг друга. Межличностное восприятие мультимодально, а выражение и идентификация унимодальных экспрессий выступают в ином качестве — одной из образующих более сложного функционального целого. Ее свойства и закономерности на сегодняшний день изучены недостаточно.

Цель данной работы состоит в том, чтобы экспериментально раскрыть специфику выражения и восприятия просодической образующей мультимодальных аффективных состояний. Это предполагает:

1) разработку методики изучения особенностей выражения и восприятия эмоционального состояния человека по интонациям его голоса как части мультимодального целого;

2) анализ характеристик точности и семантической структуры выражения и идентификации вокальных экспрессий и их зависимости от условий экспозиции;

3) соотнесение основных метрик выражения и идентификации вокальных и мультимодальных эмоциональных состояний.

В данном контексте выражение эмоций и их идентификация являются полюсами единого акта межличностного взаимодействия, благодаря которому экспрессия натурщиков обусловливает содержание воспринимаемого, а оценка слушателей отражает состав и структуру проявления переживаний.

Методика

Основу методики составляет Женевский тест распознавания эмоций (Geneva Emotion Recognition Test) — GERT, разработанный научной группой Клауса Шерера для изучения выражения и идентификации мультимодальных динамических эмоциональных состояний и их производных [Scherer, 2005; Schlegel, 2017; Schlegel, 2014]. Тест позиционируется как адекватный способ оценки переживаемых эмоций в том виде, в котором они встречаются в реальной жизни. Для академических исследований особенно интересен расширенный набор аудиовидеоизображений ключевых эмоций. Он создавался при участии профессиональных актеров, которые проходили специальную подготовку под руководством известного режиссера, Андреа Новикова. В работе с актерами использовался метод переживания К.С. Станиславского, благодаря которому режиссер создавал настроения, инициирующие требуемое функциональное состояние. Аудиовидеоклипы включали мимику, жесты, движение глаз и головы, а также псевдолингвистические фразы, содержащие интонации выражаемой эмоции. Последние создавались специалистами по фонетике и на слух соответствовали звучанию фраз на западно-европейских языках. Использовались две формы высказываний: a) с восклицательной интонацией — «Ne kali bam sud molen!» и б) с вопросительной — «Kun se mina lod belam?». По смысловому значению: a) «Не могу в это поверить!» и б) «Ты действительно так считаешь?». Аудиозаписи актеров-дикторов различаются ударениями, паузами, тембром, темпом и тоном речи, которые в совокупности создают уникальные способы вокализации эмоциональных состояний. Подбор аудиовидеоизображений строился на следующих принципах: 1) наиболее высокий уровень правдоподобия и аутентичность проявления эмоции; 2) широкий диапазон сложности оценок, необходимый для исключения концентрации ответов на наиболее точно распознаваемых аудиовидеоизображениях; 3) сбалансированность пола актеров и двух видов псевдолингвистических предложений. Раш-тестпозволил исключить сложные для распознавания видеоизображения и учесть уровень развития способности распознавать эмоцию в качестве латентного признака [6;40].

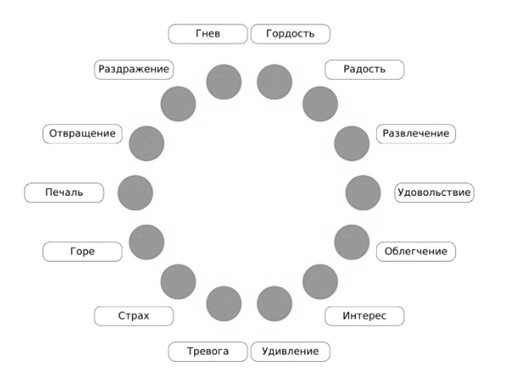

Организация стимульного материала, средства его оценки и интерпретация данных построены на концепте «Женевского колеса эмоции» — объединении в круг 14 категорий эмоциональных состояний, проранжированных в зависимости от их валентности и степени возбуждения [Bänziger, 2012; Scherer, 1986].

Наше собственное исследование проводилось в рамках русскоязычной версии GERT, в которой воспроизведены схема и ключевые звенья оригинала [4—8]. Эксперимент состоял из двух серий. В одной испытуемым демонстрировались мультимодальные аффективные состояния, в другой — их просодические образующие. Аудиодорожки извлекались из аудиовидеороликов с помощью программы iMovie. Требовалось определить содержание воспринятой эмоции, указав на соответствующую категорию изображения «Женевского колеса». Техническая реализация эксперимента осуществлялась на электронных платформах Vercel, Google Sheets.

Участники исследования. В экспериментах приняли участие студентки и аспирантки российских вузов, постоянно проживающие в г. Москве. Выборка для оценки вокальных экспрессий включала 72 женщины в возрасте от 18 до 45 лет (M=26,2, SD — 7,19); выборка для оценок мультимодальных экспозиций — 72 женщины в возрасте от 18 до 45 лет (M=22,47, SD — 5,7).

Процедура. Исследование проводилось в лаборатории Института экспериментальной психологии МГППУ на компьютерах SINTO (AMD Ryzen 3 3100, Radeon RX570, 8 GB ОЗУ) с мониторами Acer XF252QXbmiiprzx (23,5”, 1920х1080 px.), использовались наушники Sennheiser HD555 (15-28кГц, 113 дб), Canyon CNR-HS01N (20-20кГц, 106 дб), Logitech H111 (20-20кГц, 100 дб). Дисплей располагался на расстоянии 60см от лица испытуемого. Размер изображения — около 18×24°, лица — 8×10°. Аудиофрагменты передавались участникам исследования через наушники. Громкость и качество звука настраивались испытуемыми индивидуально.

Рис. 1. Снимок экрана интерактивной версии «Женевского колеса эмоций»

На начальном этапе участникам исследования сообщались технические требования, инструкция, необходимая для успешного выполнения задания и определения тестируемых эмоциональных состояний; предоставлялась возможность настроить звук. После выполнения тренировочных заданий участник имел возможность вернуться к инструкции повторно.

Во время основной сессии участникам последовательно, в зависимости от группы, в случайном порядке предъявлялись 83 аудиозаписи либо аудиовидеозаписи эмоциональных экспрессий десяти актеров (5 мужчин и 5 женщин, средний возраст — 37 лет). Распределение натурщиков по аудиовидеоклипам было неравномерным. Экспрессии отвращения, печали, горя, удивления выражены четырьмя актерами; гнев и гордость — пятью; радость, развлечение, удовольствие, облегчение, интерес, тревога, страх, раздражение — шестью. Одни и те же актеры могли участвовать в проигрывании состояний в разных объединениях — по шесть, в отдельных случаях пять эмоций [Барабанщиков, 2022а]. Каждая экспозиция демонстрировалась один раз на 3—5 с без возможности повтора; после его демонстрации на экране дисплея предъявлялось «Колесо эмоций» (рис. 1). Переход к следующей экспозиции осуществлялся автоматически после выбора категории и касания на экране соответствующего круга. Программа исследования завершалась высвечиванием на экране усредненного результата точности распознавания, полученного испытуемым, и его отчетом об особенностях выполнения задания.

Обработка данных. Анализировались усредненные показатели распознавания предъявляемых стимулов, их отношения и зависимости. При анализе структуры категориальных полей использовались усредненные оценки каждой из категорий с порогом узнавания выше 0,05. Ответы участников перекодировались в цифровые значения категорий от 1 до 14 соответственно. Полученные данные проходили предварительную обработку в MS Office, Excel 2010. Для целей статистического анализа использовался пакет программ — SPSS 22.0. Взаимосвязи средней точности оценок демонстрируемых состояний с формами высказываний и полом натурщиков определялись с помощью коэффициентов корреляции Спирмена, p<0,05. В качестве статистических критериев применялись: критерий c2 Фридмана, критерий Краскелла—Уолиса с уровнем значимости p<0,01, критерий Вилкоксона с уровнем значимости p<0,05; G-критерий Макнемара для зависимых выборок, с уровнем значимости p<0,05.

Результаты и обсуждение

Обобщенные оценки (частота выбора) мульти- и унимодальных аффективных состояний натурщиков в зависимости от категории эмоций представлены в табл. 1 и 2 соответственно. По горизонтали расположены целевые состояния, по вертикали — ответы испытуемых. Вдоль основной диагонали показаны релевантные оценки, характеризующие точность идентификации. Иррелевантные оценки, расположенные вертикально, указывают на воспринимаемое сходство целевой экспрессии с нецелевыми. Совокупность искомых значений каждого из столбцов (аффективные профили) отражает категориальную структуру полей целевого аффективного состояния.

Таблица 1. Матрица оценок мультимодальных экспрессий эмоциональных состояний натурщиков

|

Состояния |

Гордость |

Радость |

Развлечение |

Удовольствие |

Облегчение |

Интерес |

Удивление |

Тревога |

Страх |

Горе |

Печаль |

Отвращение |

Раздражение |

Гнев |

|

Гордость |

0,47 |

0,09 |

0 |

0,04 |

0,02 |

0,01 |

0 |

0 |

0 |

0 |

0 |

0 |

0,01 |

0 |

|

Радость |

0,16 |

0,76 |

0,18 |

0,04 |

0,02 |

0,02 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

|

Развлечение |

0,06 |

0,06 |

0,68 |

0,01 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

|

Удовольствие |

0,1 |

0,01 |

0,03 |

0,79 |

0,12 |

0,01 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

|

Облегчение |

0,01 |

0,03 |

0,01 |

0,06 |

0,77 |

0,02 |

0,01 |

0,02 |

0 |

0 |

0,02 |

0 |

0,02 |

0 |

|

Интерес |

0,09 |

0,01 |

0 |

0,05 |

0,02 |

0,57 |

0,11 |

0,06 |

0 |

0 |

0,01 |

0 |

0,06 |

0 |

|

Удивление |

0,01 |

0,04 |

0,05 |

0 |

0 |

0,14 |

0,65 |

0,16 |

0,03 |

0 |

0,01 |

0,03 |

0,05 |

0 |

|

Тревога |

0 |

0 |

0 |

0 |

0 |

0,02 |

0,1 |

0,58 |

0,12 |

0,11 |

0,02 |

0,03 |

0,04 |

0 |

|

Страх |

0 |

0 |

0 |

0 |

0 |

0 |

0,02 |

0,13 |

0,6 |

0,08 |

0,01 |

0,02 |

0 |

0 |

|

Горе |

0 |

0 |

0,02 |

0 |

0,01 |

0,02 |

0,02 |

0,02 |

0,13 |

0,61 |

0,22 |

0,08 |

0,02 |

0,01 |

|

Печаль |

0 |

0 |

0 |

0 |

0 |

0,03 |

0,01 |

0,03 |

0 |

0,12 |

0,66 |

0,07 |

0,01 |

0 |

|

Отвращение |

0,01 |

0 |

0,01 |

0 |

0,01 |

0,03 |

0,03 |

0 |

0 |

0,02 |

0,03 |

0,65 |

0,08 |

0 |

|

Раздражение |

0,05 |

0 |

0 |

0 |

0,02 |

0,12 |

0,06 |

0 |

0,03 |

0,03 |

0,02 |

0,1 |

0,67 |

0,22 |

|

Гнев |

0,02 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0,08 |

0,03 |

0 |

0,01 |

0,04 |

0,75 |

Таблица 2. Матрица оценок вокальных экспрессий эмоциональных состояний натурщиков

|

Состояния |

Гордость |

Радость |

Развлечение |

Удовольствие |

Облегчение |

Интерес |

Удивление |

Тревога |

Страх |

Горе |

Печаль |

Отвращение |

Раздражение |

Гнев |

|

Гордость |

0,17 |

0,02 |

0 |

0,03 |

0,02 |

0,1 |

0,02 |

0,01 |

0 |

0,03 |

0,02 |

0,09 |

0,05 |

0,03 |

|

Радость |

0,08 |

0,33 |

0,32 |

0,03 |

0,01 |

0,02 |

0,03 |

0 |

0,01 |

0,03 |

0 |

0,02 |

0,01 |

0,03 |

|

Развлечение |

0,04 |

0,09 |

0,42 |

0,01 |

0 |

0,02 |

0,09 |

0 |

0 |

0,01 |

0,01 |

0,02 |

0 |

0,01 |

|

Удовольствие |

0,02 |

0,02 |

0,01 |

0,71 |

0,18 |

0,15 |

0,06 |

0,02 |

0 |

0 |

0,04 |

0,1 |

0,01 |

0 |

|

Облегчение |

0,01 |

0,01 |

0 |

0,12 |

0,57 |

0,13 |

0,03 |

0,04 |

0 |

0,02 |

0,08 |

0,05 |

0,07 |

0 |

|

Интерес |

0,15 |

0 |

0 |

0,03 |

0,02 |

0,17 |

0,33 |

0,24 |

0 |

0 |

0,06 |

0,02 |

0,15 |

0 |

|

Удивление |

0,17 |

0,04 |

0 |

0 |

0,01 |

0,03 |

0,33 |

0,17 |

0,01 |

0,01 |

0,02 |

0,05 |

0,1 |

0,01 |

|

Тревога |

0,03 |

0,04 |

0 |

0 |

0,05 |

0,03 |

0,05 |

0,27 |

0,22 |

0,13 |

0,05 |

0,05 |

0,06 |

0,03 |

|

Страх |

0,01 |

0,08 |

0 |

0 |

0,01 |

0 |

0,01 |

0,06 |

0,51 |

0,12 |

0,02 |

0,03 |

0 |

0,01 |

|

Горе |

0,01 |

0,26 |

0,2 |

0,01 |

0,01 |

0,01 |

0 |

0,01 |

0,03 |

0,34 |

0,16 |

0,05 |

0 |

0 |

|

Печаль |

0,02 |

0,05 |

0,03 |

0,03 |

0,06 |

0,17 |

0,03 |

0,15 |

0,01 |

0,2 |

0,52 |

0,06 |

0,04 |

0 |

|

Отвращение |

0,07 |

0,01 |

0 |

0,01 |

0,02 |

0,05 |

0,01 |

0,01 |

0,02 |

0,04 |

0,02 |

0,22 |

0,1 |

0,03 |

|

Раздражение |

0,14 |

0,01 |

0 |

0,02 |

0,02 |

0,11 |

0,02 |

0,01 |

0,06 |

0,06 |

0,02 |

0,2 |

0,37 |

0,36 |

|

Гнев |

0,08 |

0,03 |

0 |

0 |

0 |

0 |

0 |

0 |

0,13 |

0,01 |

0 |

0,03 |

0,04 |

0,5 |

Процедура сепарации голосовой составляющей разнокачественных аффективных экспрессий предоставляет возможность более детально рассмотреть особенности выражения и восприятия вокальных эмоций по отношению к характеристикам мультимодальных состояний, полученных в данной и предыдущих работах [4—8].

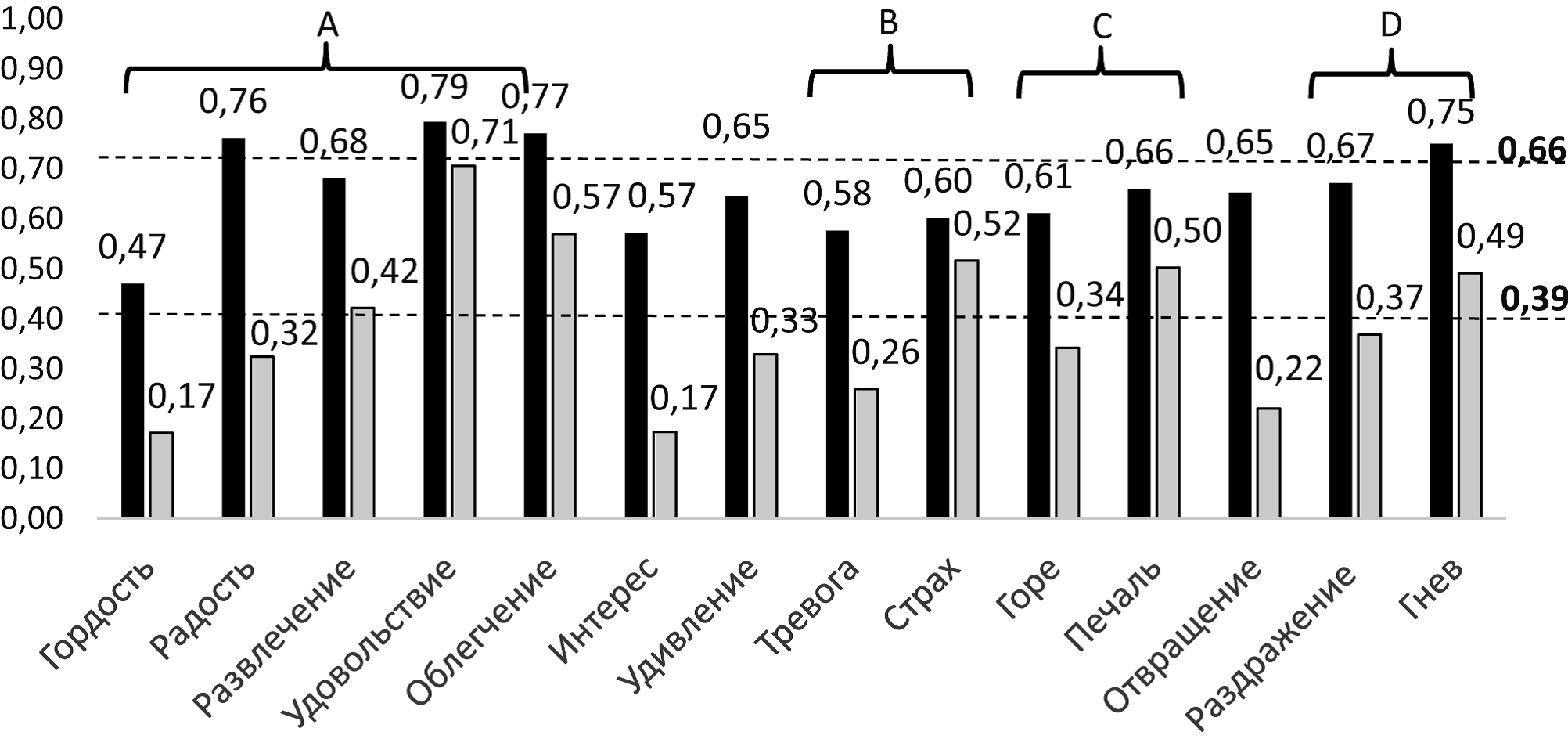

Рис. 2. Гистограммы точности распознавания эмоций по интонациям голоса и мультимодальным экспрессиям (лицо + голос). По горизонтали — экспонируемые категории эмоций, по вертикали — частота релевантных ответов испытуемых. Цифры сверху — средние значения частоты ответов для каждой категории эмоций; пунктирные линии — средние значения частоты ответов на экспозиции вокальных и мультимодальных экспрессий. A, B, C, D — аффективные группы; — вокальные экспрессии; — мультимодальные экспрессии

Точность идентификации вокальных экспрессий. Первое, что обращает на себя внимание — это низкий средний уровень точности оценок вокальных экспрессий (М=0,39+/– 0,16) (рис. 2). В наших экспериментах с мультимодальным стимульным материалом, включающим точно такую же акустическую составляющую, полученные значения более чем в полтора раза (1,6—1,8) выше. Средние значения точности идентификации ряда мультимодальных экспрессий отличаются от вокальных еще больше: выражения интереса — в 3,6 раз, отвращения — в 3 раза, гордости — в 2,8 раз. Это ожидаемо указывает на трудность выражения голосовых экспрессий по отношению к лицевым, что показывают и унимодальные сравнения, а также на их открытость кроссмодальным взаимодействиям и более полную информацию, которую несут интегрированные выражения эмоций [Dolan, 2001; Gelder, 2000].

Серьезно различаются и конфигурации точности оценок вокальных и мультимодальных экспрессий. При голосовых выражениях максимально точно распознается только удовольствие (0,71), наименее точно — гордость (0,17), интерес (0,17) и отвращение (0,22). В условиях мультимодальности лучше всего, наряду с удовольствием (0,79), воспринимаются облегчение (0,77), радость (0,76) и гнев (0,75);хуже всего — гордость (0,47), интерес (0,57) и тревога (0,58). Даже радость, известная в литературе (благодаря зрительной модальности) как очень точно и устойчиво узнаваемое эмоциональное состояние, по голосу оценивается ниже средних значений. В рейтингах оценок мульти- и унимодальных (вокальных) экспрессий одни и те же эмоции могут занимать противоположные позиции, как, например, в случаях страха или печали. Дивергенция значений конфигураций точности идентификации вокальных и мультимодальных экспрессий позволяют допустить множественность сочетаний разномодальных оценок аффективных состояний людей в условиях, приближенных к экологически валидным, и соответствующие им механизмы интеграции.

Точность идентификации вокальных экспрессий соотносима с функциональными свойствами аффективных групп, что в целом также соответствует данным исследований унимодальных вокальных экспрессий. Распознавание эмоций с положительной валентностью (группа А), даже с учетом низких оценок гордости, остается выше общего среднего уровня (0,45+/–0,26), как и оценки вокальных эмоций с отрицательной валентностью — аффективных групп B, C, D, соотношения значений точности идентификации которых между собой очень похожи (0,41+/–0,18). Распознавание амбивалентных вокальных эмоций почти в два раза хуже (0,25+/–0,22); возникают вопросы о его адекватности. Складывается впечатление, что четко выражаемая валентность является фактором эффективности восприятия унимодальных эмоций данного типа. В условиях мультимодальной экспозиции резкое падение точности идентификации амбивалентных состояний не наблюдалось.

Точность идентификации и степень возбуждения диктора. В условиях мультимодальной экспозиции прогнозируемый рост точности идентификации с увеличением степени возбуждения имеет место только по отношению к состояниям группы D [5, 6]. При предъявлении унимодальных вокальных экспрессий в качестве образующих мультимодальных состояний линейная зависимость результата распознавания от возбуждения отмечается во всех тестируемых группах B, C, D. Эмоции с более высокой степенью возбуждения дикторов идентифицируются точнее: тревога (0,26) и страх (0,52), z = –3,861, p<0,01; горе (0,34) и печаль (0,50), z = –5,84, p<0,01; раздражение (0,37) и гнев (0,49), z = —3,861, p<0,01. Средние значения точности распознавания вокальных эмоций для групп B, C и D статистически не различимы (М = 0,39; 0,42; 0,43 соответственно), а соотношения значений родственных категорий находится на одном уровне.

Точность идентификации вокальных экспрессий и акустический контур высказывания. Высказывания дикторов в каждой экспозиции содержат законченную мысль и выражают переживание соответствующих аффективных состояний. Вопросительные суждения, как правило, завершаются повышением тона голоса, восклицательные повествования — его повышением или понижением, которые определяются содержанием и контекстом эмоции. Поскольку изменение тона является одним из важных акустических признаков мелодики речи, можно ожидать, что разные акустические контуры использованных в эксперименте фраз способны повлиять на оценку аффективных состояний. Выполненные расчеты показывают, что, несмотря на отдельные эпизоды, в которых повышение тона в конце высказывания действительно увеличивает точность идентификации эмоции (об этом сообщают и участники эксперимента), значимые корреляции между типом высказывания и совокупными оценками состояния дикторов по голосу не обнаружены. Факты повышения/понижения точности восприятия эмоций в связи с изменением тона голоса требуют дополнительного исследования.

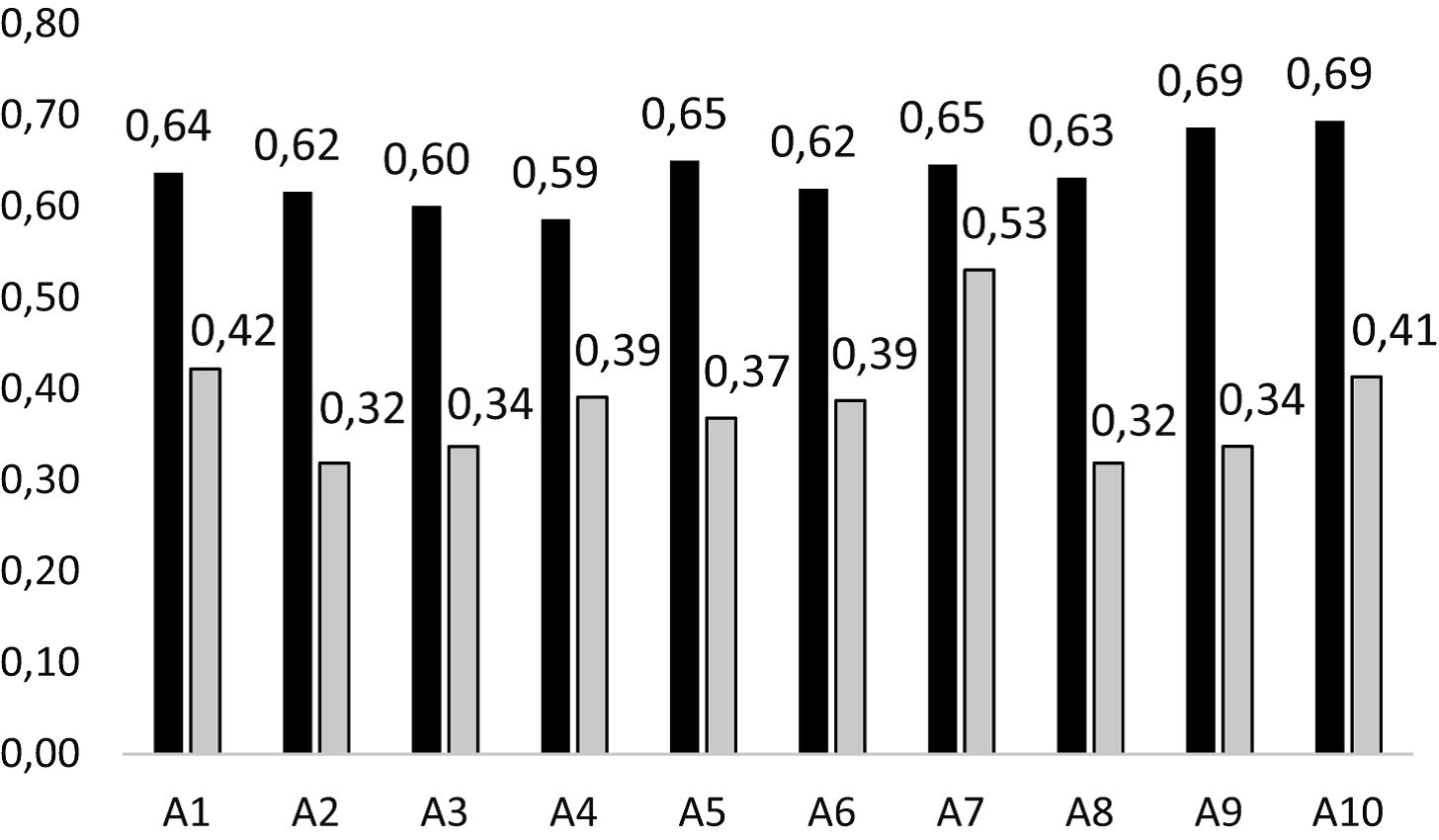

Выражение и восприятие вокальных экспрессий. Среди детерминант восприятия аффективных состояний особое место занимают способы их выражения разными натурщиками. На рис.3 показана средняя точность вокализаций эмоций по отношению к индивидуальным способам объективации мультимодальных состояний каждого из дикторов-актеров.

Рис. 3. Средняя точность вокализации эмоций и ее соотношение с оценками мультимодальных эмоциональных состояний, выраженных актерами (An); —вокальные экспрессии; —мультимодальные экспрессии

Максимальные значения точности вокализаций получены натурщиком А7. Это единственный диктор, достигающий сопоставимой точности со значениями мультимодальных выражений. Результаты, показанные остальными девятью дикторами, в 1,6 раза хуже. Наименее точные вокализации выполнены натурщиками А2, А3, А8, и А9. Эффект фасилитации — повышение точности идентификации эмоций при использовании дополнительных каналов однотипной информации [Gelder, 2000; Schirmer, 2017] продемонстрирован всеми актерами (А7 — как тенденция).

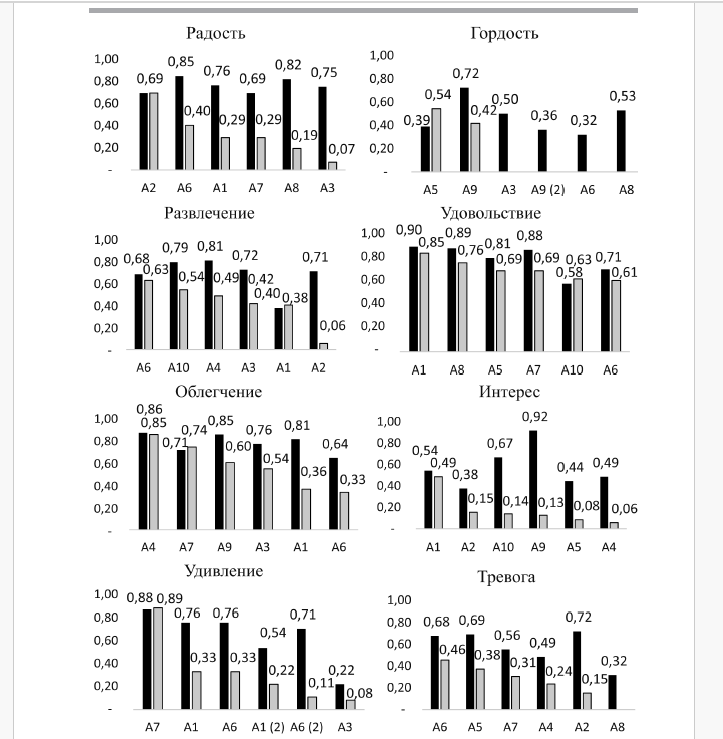

Рис. 4. Рейтинги точности выражения вокальных экспрессий разными натурщиками в зависимости от содержания эмоций; вверху — целевая категория эмоции, внизу — идентификационные номера дикторов-актеров, An; An (2) указывает на участие одного и того же актера в демонстрации разных объединений эмоций. — вокальные экспрессии; — мультимодальные экспрессии

В зависимости от категории целевой эмоции рейтинги точности выражений меняются. Как правило, первые позиции занимают разные натурщики (рис. 4). С каждой новой целевой категорией они как бы вновь перемешиваются, занимая в рейтинге иные места. Также, как и выражения мультимодальных состояний, вокализации модальноспецифичны. В частности, при выражении голосом эмоций группы B диктор А8 может находиться в конце одного (тревога) и вначале другого (страх) списка. На уровне мультимодальных экспозиций это приводит к сочетаниям, при которых оценки одной из образующих снижаются до предельно низких значений или исключаются вовсе (отвращение и развлечение, выраженные А2; радость, выраженная А3).

За некоторым исключением первые позиции занимаются дикторами, точность вокализаций целевой эмоции которых соответствует уровню выражения мультимодальных состояний, и кратно отличается от вокализаций других дикторов. В отдельных эпизодах адекватная вокализация полностью вытесняется признаками выражения других эмоций (гордость, раздражение, тревога). Наиболее полная и эффективная вокализация с участием большинства натурщиков получена на экспрессии удовольствия, результаты которой статистически неразличимы от выражения мультимодальных состояний. Очень низкая эффективность групповой вокализации связана с эмоцией отвращения. За богатой феноменологией унимодальных экспрессий стоит широкий диапазон индивидуальных средств и способов вокализаций эмоций.

Согласно полученным данным полнота и точность выражения вокальных и мультимодальных аффективных состояний в значительной степени не совпадают. При исключении лицевых экспрессий вокализации одних и тех же переживаний одними и теми же актерами воспринимаются иначе.

Точность выражения аффективных состояний и пол натурщиков. Ранее на материале аудиовидеоизображений эмоциональных состояний мы нашли, что почти в 80% случаев экспозиции актеров и свыше 90% случаев экспозиции актрис гендерная стилистика в характере оценок не проявляется. В отдельных фрагментах женщины точнее отыгрывают мультимодальные состояния и наиболее эффективно распознают эмоции, продемонстрированные другими женщинами. Восприятие мультимодальных состояний мужчин и женщин в целом совпадают [Барабанщиков, 2022а]. В новых экспериментах сделанный вывод подтвердился. Значения коэффициента корреляции между средней точностью вокализации эмоций и полом актеров-натурщиков стремится к нулю, как и взаимодействие между точностью выражения мультимодальных экспрессий и полом натурщика. Полученный результат расходится с рядом данных унимодальных исследований голосовых эмоций.

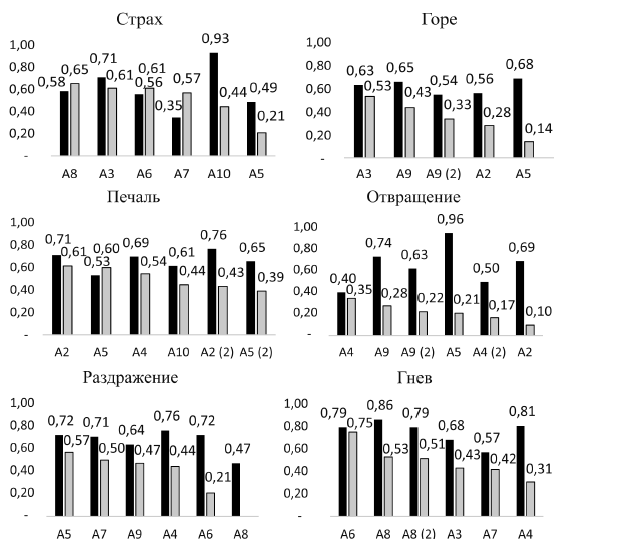

Категориальные поля вокальных экспрессий. Категориальное полеаффективного состояния характеризует структуру семантического содержания воспринимаемой эмоции. Это объединение различных впечатлений об одной и той же целевой эмоции, полученных группой испытуемых в рамках системы оценочных категорий «Женевского колеса эмоций». Как многокомпонентное образование, категориальное поле дифференцируется на ядро — наиболее точно идентифицируемые экспрессии и периферию — ассоциированные состояния, составляющие фон.

Категориальные поля мультимодальных состояний (рис. 5) характеризуются четко структурированным контуром: имеет место выраженный эксцесс точности оценок целевых эмоций, величина которого многократно превышает значение оценок компонентов периферии. С удалением позиции компонентов от расположения целевого состояния на «Колесе эмоций» их оценки снижаются, а категории противоположной валентности отсутствуют. Периферия амбивалентных целевых эмоций включает компоненты как положительной, так и отрицательной валентности.

Анализ категориальных полей вокальных экспрессий показывает, что восприятие каждой экспонируемой эмоции имеет уникальную семантическую структуру и идентифицируется слушателями иначе. Ее объем — количество аффективных компонентов и частота их обнаружения — широко варьирует. В среднем на каждую целевую категорию приходится 3—4 дополнительных экспрессии; в некоторых случаях их может быть шесть (отвращение, раздражение) или всего одна (удовольствие, гнев); в последнем случае развитая периферия отсутствует. С увеличением числа компонентов и степени их выраженности точность идентификации целевой экспрессии снижается (облегчение, страх, гнев).

Роли компонентов в структуре категориального поля связаны с их расположением на круговой шкале «Женевского колеса» относительно целевой категории. В ранее проведенных экспериментах отмечалось, что иррелевантные ответы испытуемых, как правило, являются смежными или соседствующими с целевыми [Барабанщиков, 2023; Schlegel, 2012]. Тенденция прослеживается и в условиях вокальной экспозиции, но, в отличие от мультимодальных состояний, иррелевантные оценки чаще распространяются на дальнюю периферию и включают категории противоположной валентности. Наиболее отчетливо тенденция проявляется на примере восприятия эмоций с положительной валентностью (группа А): радость (0,33) содержит компоненты горя (0,26), страха (0,08) и печали (0,05); развлечение (0,42) — радости (0,32) и горя (0,20); гордость (0,17) наряду с амбивалентными состояниями и радостью (0,08) включает раздражение (0,14), гнев (0,08) и отвращение (0,07); облегчение (0,57) вместе с удовольствием (0,18) — печаль (0,06) и тревогу (0,05). Подобные явления наблюдались и в швейцарских экспериментах, где, например, доля эмоции горя в оценках развлечения составила 0,13 [Bänziger, 2012].Расширение периферии категориального поля сопровождается более низкой точностью идентификации целевой эмоции. При экспозициивокальных экспрессий гордости (0,17), интереса (0,17) и отвращения (0,22) воспринимаемое состояние диктора сливается с фоном и/или маскируется признаками других состояний. Похожий результат получен в исследованиях К. Шерера: более трети оценок гордости составили отрицательные эмоции. Вместе с тем родственные связи положительных эмоций эффективно проявляют себя во взаимовлиянии радости и развлечения или удовольствия и облегчения. В условиях акустической модальности воспринимаемые отношения экспрессий отличаются большей вариативностью и избирательностью.

Рис. 5. Структуры категориальных полей мультимодальных и голосовых экспрессий. Вверху указаны категории экспонируемых эмоций, слева — категории ответов испытуемых, внизу — частота выбора (отмечены оценки ≥0,05); — вокальные экспрессии; —мультимодальные экспрессии

Смещение оценок в сторону дальней периферии имеет место и при экспозиции отрицательных эмоций группы B (страха, раздражения), C (печали) и D (раздражения), в которых обнаруживаются положительные экспрессии. Наиболее полно родственные связи выражены в группе C.

Амбивалентные вокальные эмоции распознаются плохо и показывают низкую согласованность семантического содержания внутри группы участников. Удивление (0,33) практически неотличимо от интереса (0,32); интерес (0,17) — от печали (0,17), удовольствия (0,15) и облегчения (0, 13); отвращение (0,22) — от раздражения (0,20). Значения точности идентификаций смежных экспрессий чаще носят ассиметричный характер.

В целом, по сравнению с восприятием мультимодальных состояний структура категориальных полей вокальных экспрессий выглядит менее определенной, более размытой и смещенной в сторону дальней периферии, а сами эмоции — менее точными и более микшированными.

Резюмируя сказанное, отметим, что вокальные экспрессии, включаясь в более объемное функциональное целое, сохраняют специфику и отличаются от соответствующих мультимодальных состояний рядом основных метрик: низкой средней точностью выражения и идентификации, иной конфигурацией и высоким разбросом оценок, более тесной зависимостью от возбуждения, индивидуальными способами выражения эмоций, семантическим содержанием и нечеткой структурой категориальных полей. Это характеристика собственных возможностей просодической образующей, ее экспрессивного потенциала. Когда, как и насколько полно он сможет реализоваться, во многом зависит от природы других образующих, входящих в систему мультимодальных отношений. Они проистекают из одного и того же переживания натурщика и благодаря этому обстоятельству сливаются в единый поток, подчиняющийся закономерностям кроссмодального целого.

Предложенный метод сепарации образующих мультимодальных экспрессий соответствует задачам выполненного исследования и имеет неплохую перспективу. Очевидно, что в рамках мультимодальных отношений вокализация эмоций занимает подчиненное положение, а доминирует динамика выражений лица. Но всегда ли? Существуют ли условия, при которых происходит обратное. Если да, то какие? Встают вопросы избирательности восприятия и динамической концентрации внимания испытуемых на лице или голосе натурщиков. Их решение ведет к понимаю конкретных механизмов интеграции унимодальных экспрессий в качественно новое целое.

Выводы

Выполненное исследование просодической образующей мультимодальных аффективных состояний человека позволяет охарактеризовать особенности ее выражения и восприятия.

- Средний уровень точности идентификации вокальных экспрессий более чем в 1,6 раза ниже точности мультимодальных состояний. Конфигурации оценок существенно различны. Их дивергенция указывает на множественность типов кроссмодальных взаимодействий и соответствующих им механизмов интеграции.

- В оценках вокальных экспрессий отражаются характеристики функциональных свойств аффективных состояний. Эмоции с положительной (группа A) либо отрицательной (группы B, C, D) валентностью воспринимаются почти в два раза точнее, чем амбивалентные. Подобное снижение в условиях мультимодальной экспозиции не наблюдается. Эффект имеет методическое значение в исследованиях и/или диагностике мультимодальных состояний.

- Идентификации вокальных экспрессий B, C, D зависят от степени возбуждения диктора: с ее ростом точность идентификации значимо повышается. В условиях мультимодальности линейные отношения между точностью оценок и степенью возбуждения воспроизводятся только в группе D.

- Изменение тона в вопросительных и отрицательных фразах, произносимых дикторами-актерами, эпизодически влияют на оценку слушателей, но с общей точностью идентификации не коррелируют.

- Как и проявления мультимодальных состояний, выражения эмоций голосом для каждого натурщика модально-специфичны, обусловлены ее категорией. С изменением содержания целевой эмоции рейтинги точности вокализации натурщиков меняются. В отдельных эпизодах адекватная вокализация полностью вытесняется признаками других экспрессий.

- Значения коэффициентов корреляции между средней точностью вокализаций эмоций и полом натурщиков, а также между средней точностью выражения мультимодальных экспрессий и полом актеров стремятся к нулю.

- Выражение каждой эмоции имеет уникальный экспрессивный состав, который по-разному идентифицируется слушателями. Количество экспрессивных компонентов и частота их обнаружения широко варьируют. В среднем на каждую целевую категорию приходятся 2—4 дополнительные экспрессии; с увеличением их числа и степени выраженности точность идентификации эмоции снижается. В условиях мультимодальности тенденция сохраняется.

- Категориальные поля мультимодальных состояний отличаются четко выраженным ядром и анизотропной периферией, ограниченной валентностью целевой эмоции. Структура категориальных полей вокальных экспрессий менее определена, более размыта и смещена в сторону дальней периферии, охватывающей категории противоположной валентности.

- Обозначен экспрессивный потенциал просодической образующей в системе мультимодальных отношений интонаций голоса и динамических экспрессий лица.